OpenWebUI

OpenWebUI to bogaty w funkcje i przyjazny, self-hosted interfejs AI zaprojektowany do działania całkowicie offline. Obsługuje różne metody używania LLM takie jak Ollama i OpenAI API.

Jak uruchomić

Dostępne są dwie opcje wykorzystania modeli LLM:

- Dedykowana instancja: Wymaga wynajmu dedykowanej karty graficznej potrzebnej do uruchomienia własnego modelu przy pomocy LLama.cpp na CGC, zapewniając pełną kontrolę nad modelem

- Współdzielona instancja: Pozwala na korzystanie z gotowych modeli dostępnych przez LLM-API CGC, co jest bardziej ekonomicznym rozwiązaniem, gdyż nie wymaga wynajmu dedykowanej karty graficznej.

Aby uruchomić zasób obliczeniowy OpenWebUI, użyj następującej komendy w CLI CGC, zalecamy co najmniej 2 rdzenie procesora i 2GB pamięci RAM:

cgc compute create -c 2 -m 2 -n <your_compute_name> -e openai_api_key=<your_api_key> -v <your_volume_name> open-webui

Wymagane parametry

OPENAI_API_KEY: Twój klucz API OpenAI umożliwiający korzystanie z LLM. Aby używać modeli z LLM-API, wygeneruj klucz API LLM-API.

Domyślna konfiguracja

CUSTOM_NAME: Nazwa instancji OpenWebUI, ustawiona na nazwę, którą podajesz.OPENAI_API_BASE_URL: Bazowy URL dla OpenAI API, domyślnie ustawiony nahttps://llm.comtegra.cloud/v1.

Opcjonalna konfiguracja

RAG_OPENAI_API_BASE_URL: Bazowy URL dla RAG OpenAI API, jeśli zostanie podany:RAG_EMBEDDING_MODEL: Model embeddingu do użycia, domyślniegte-qwen2-7b.RAG_EMBEDDING_ENGINE: Silnik embeddingu do użycia, domyślnieopenai.

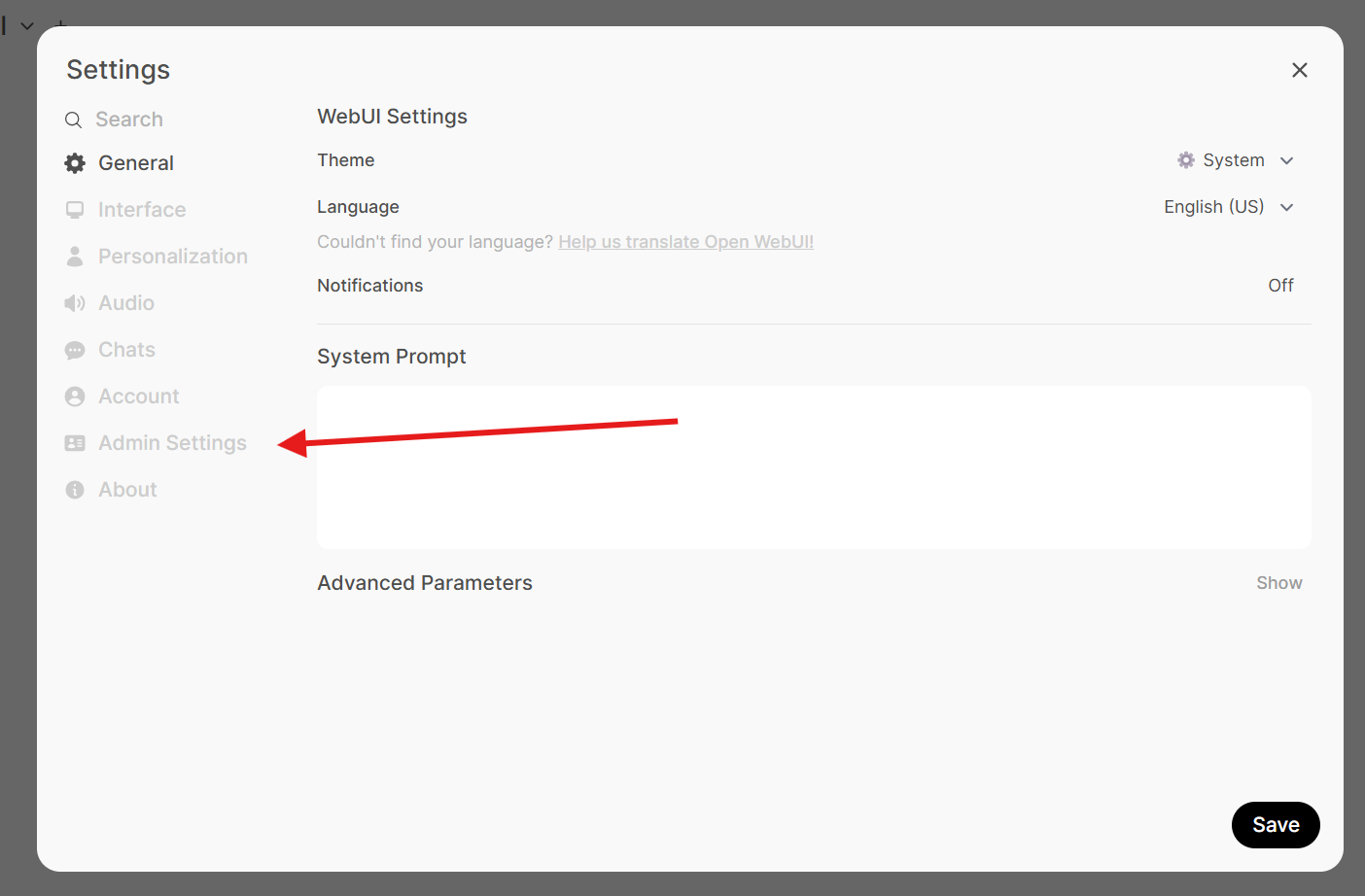

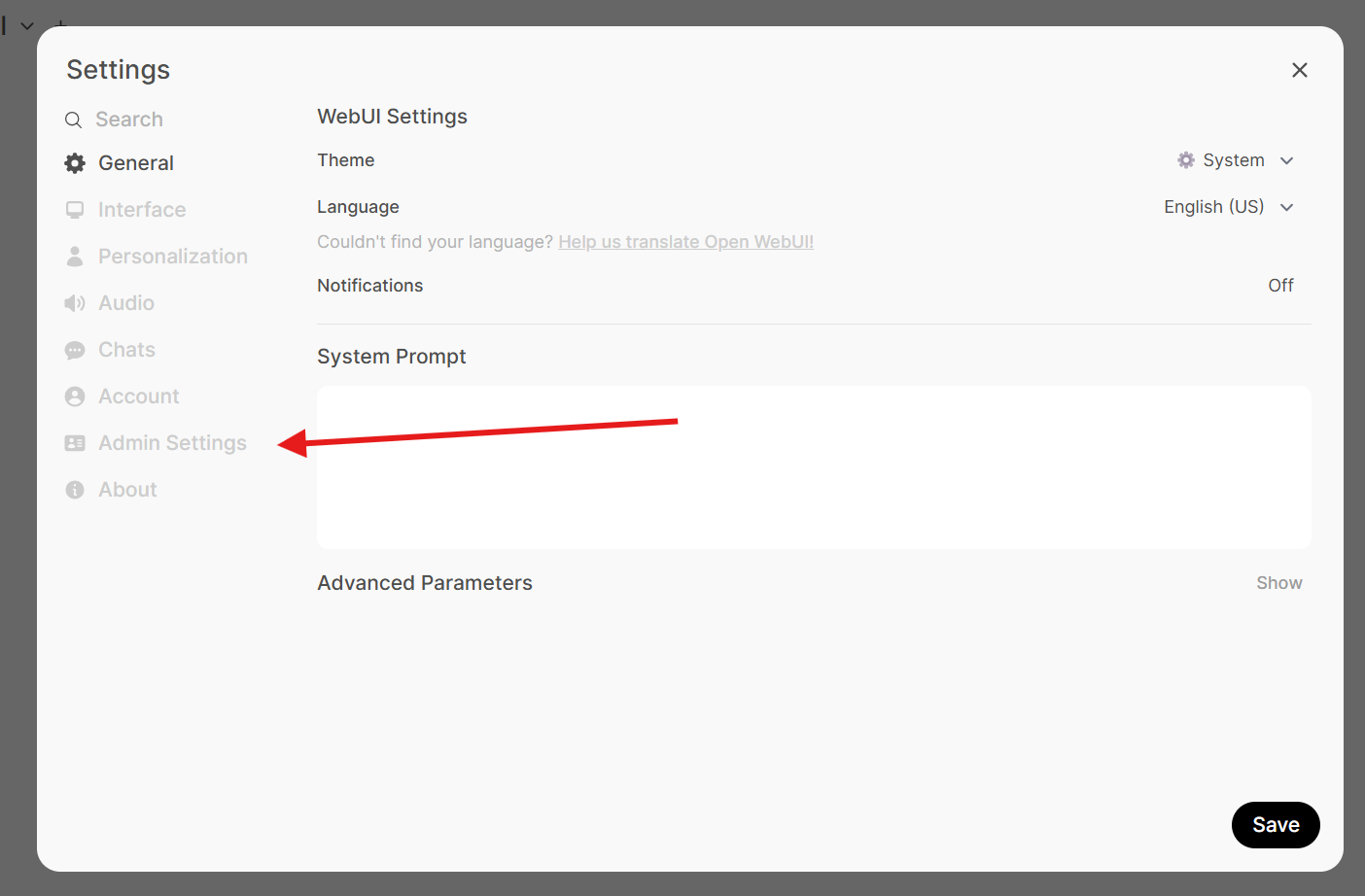

W przypadku pomyłki w zmiennych środowiskowych, możesz je później zmienić w panelu Admin Settings.

Rejestracja i konfiguracja

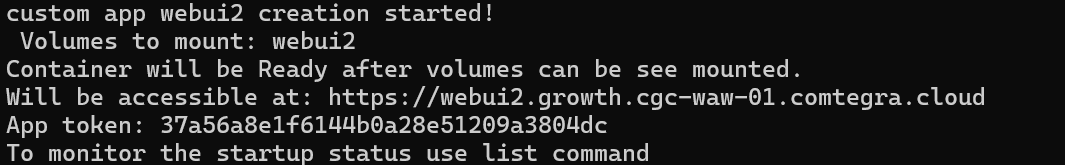

Po uruchomieniu zasobu obliczeniowego w CLI CGC powinieneś zobaczyć informacje o utworzeniu zasobu obliczeniowego OpenWebUI oraz URL i token aplikacji umożliwiający dostęp do interfejsu OpenWebUI.

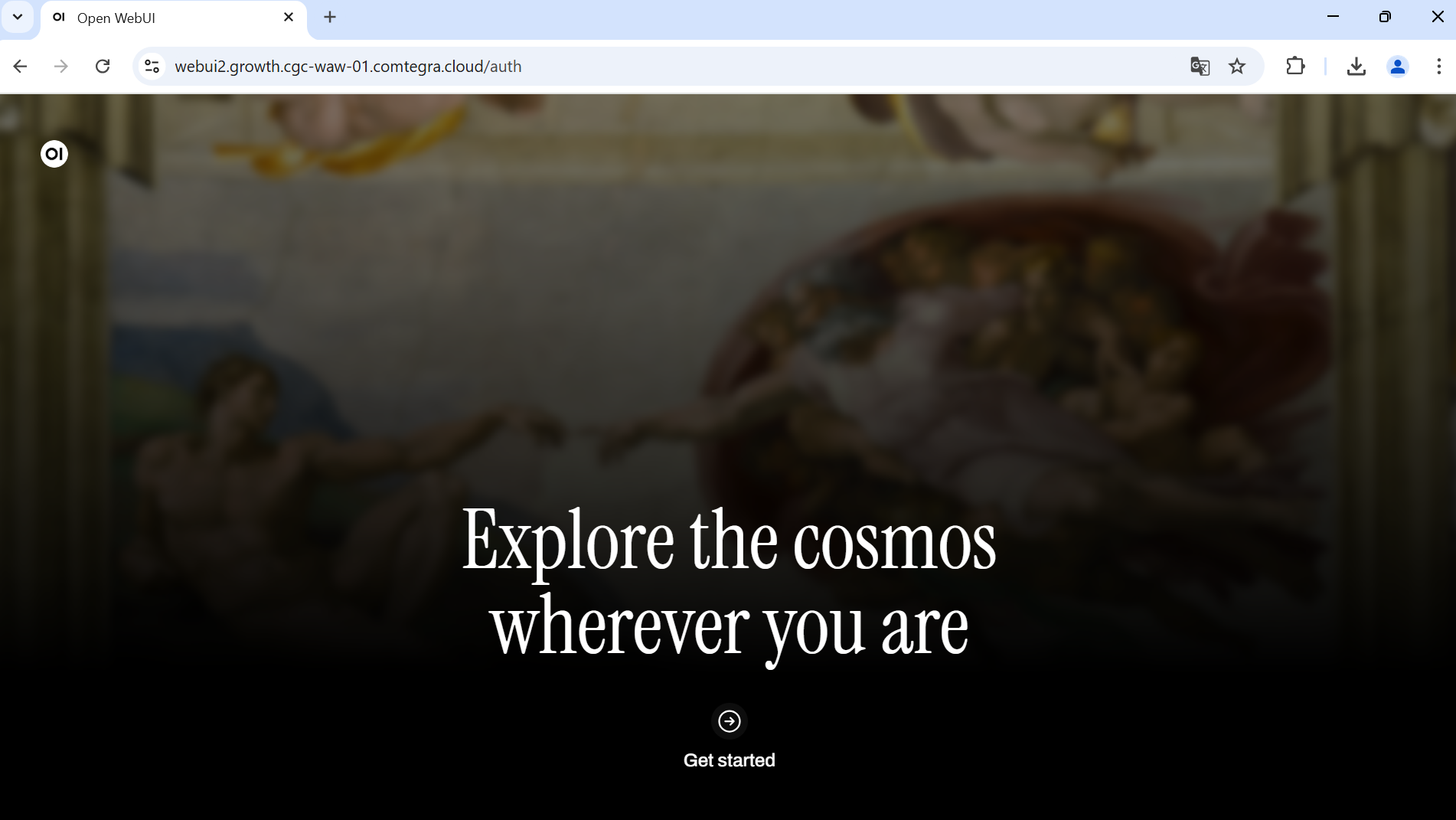

W przeglądarce przejdź do URL podanego w CLI, powinieneś zobaczyć interfejs OpenWebUI.

Kontynuuj klikając przycisk Get started.

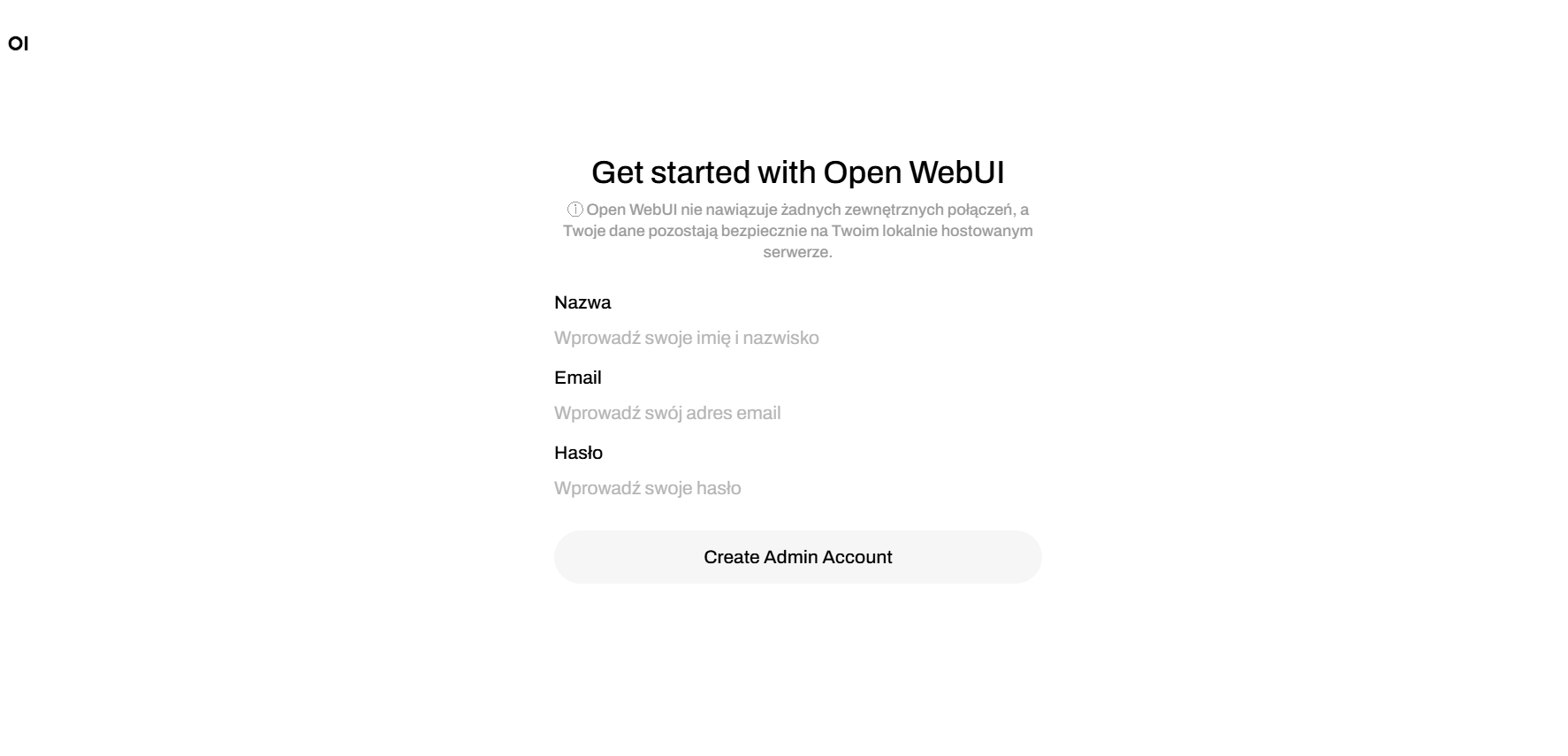

W kolejnym kroku zostaniesz poproszony o utworzenie konta administratora. Zarejestruj się za pomocą adresu e-mail i hasła.

OpenWebUI nie wykonuje żadnych połączeń na zewnątrz, twoje dane w tym mail i hasło są bezpiecznie przechowywane lokalnie.

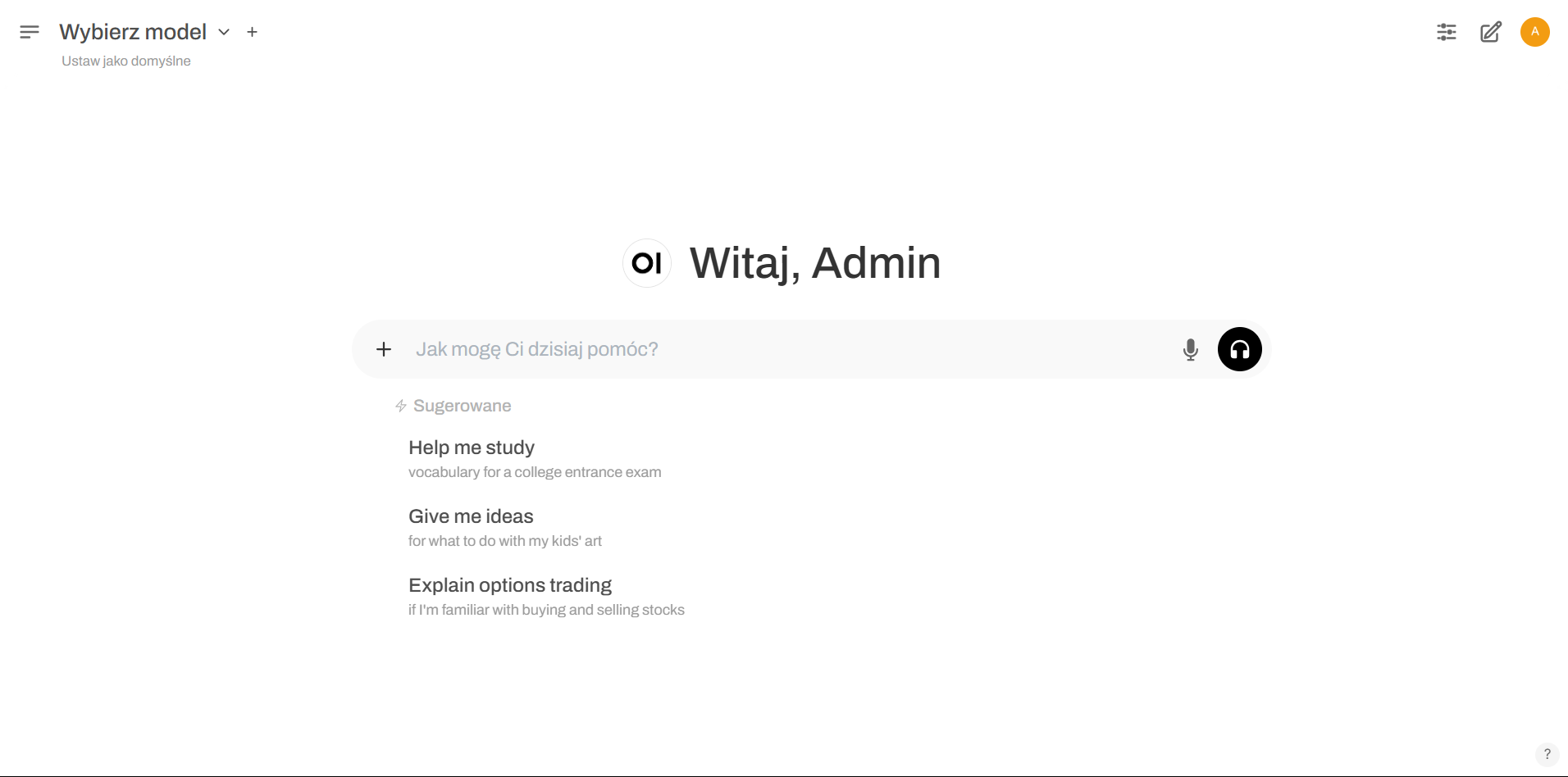

Po zarejestrowaniu zostaniesz przekierowany do interfejsu OpenWebUI.

Konfiguracja dostawcy LLM

Jeśli skonfigurowałeś zasób obliczeniowy z LLM-API podczas tworzenia zasobu obliczeniowego, możesz pominąć ten krok.

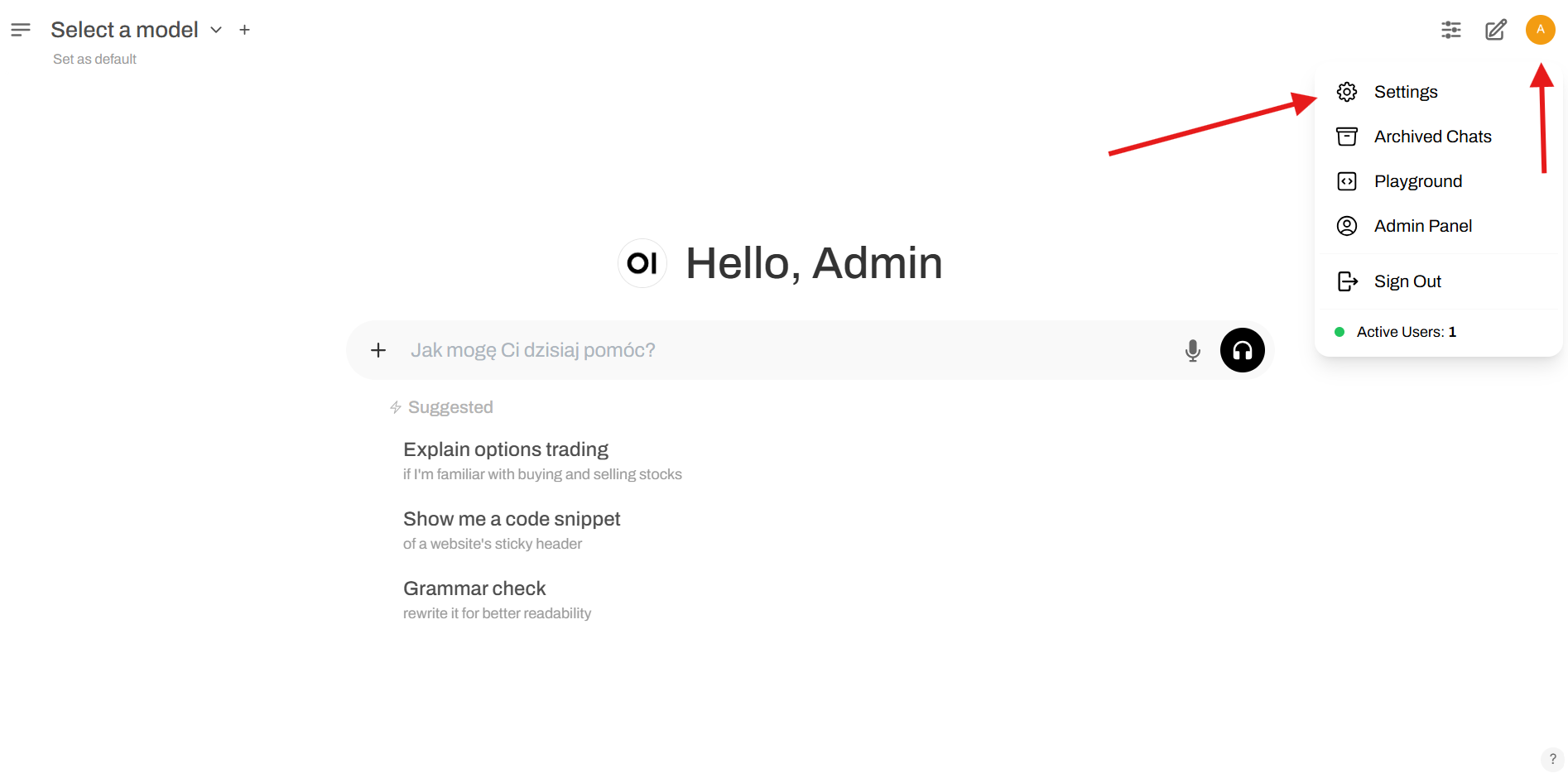

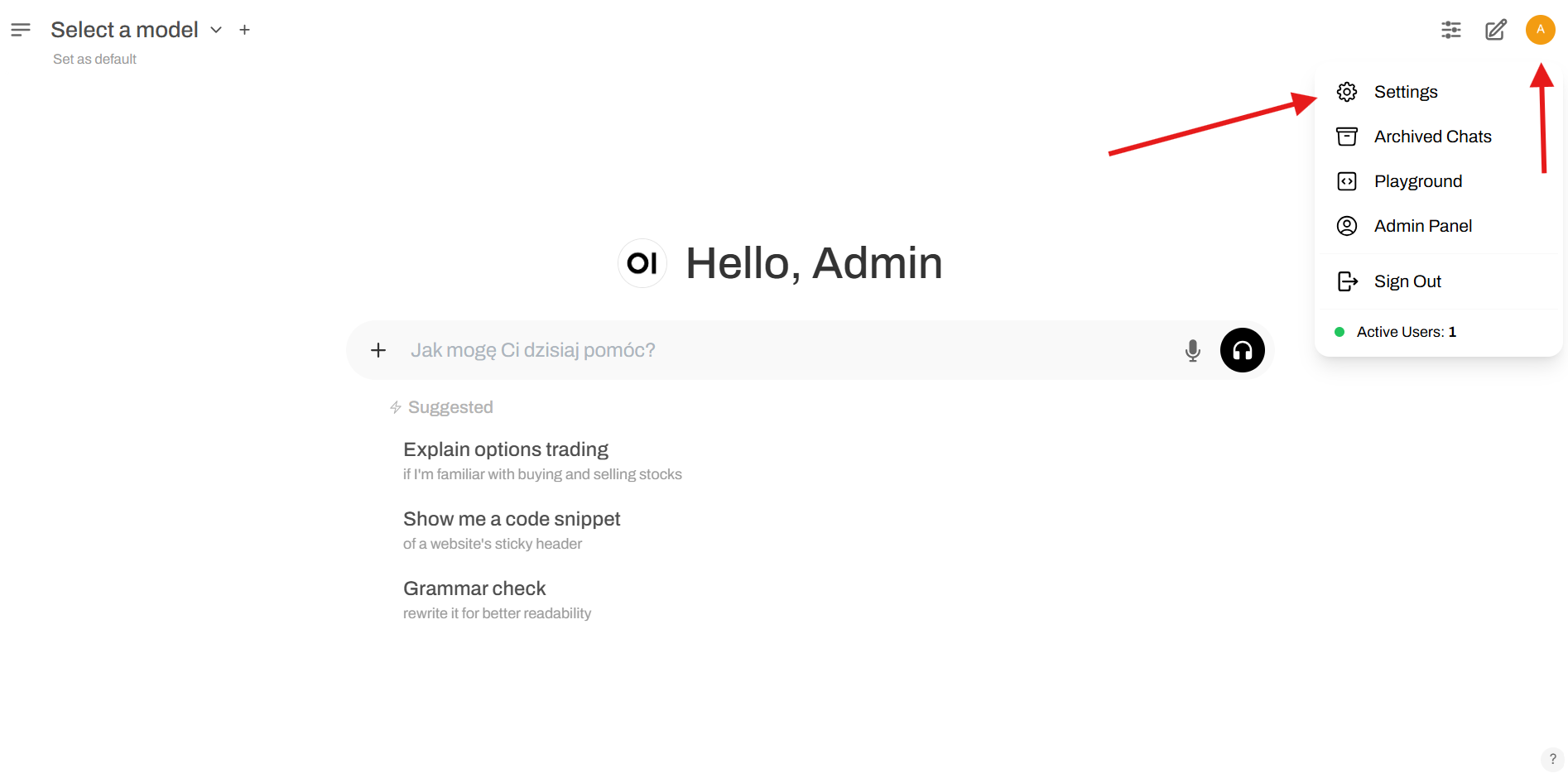

Zanim będziemy mogli skorzystać z interfejsu chatu, musimy skonfigurować dostawcę LLM. Aby to zrobić, kliknij przycisk Settings w prawym górnym rogu interfejsu.

W panelu ustawień wybierz Admin Settings.

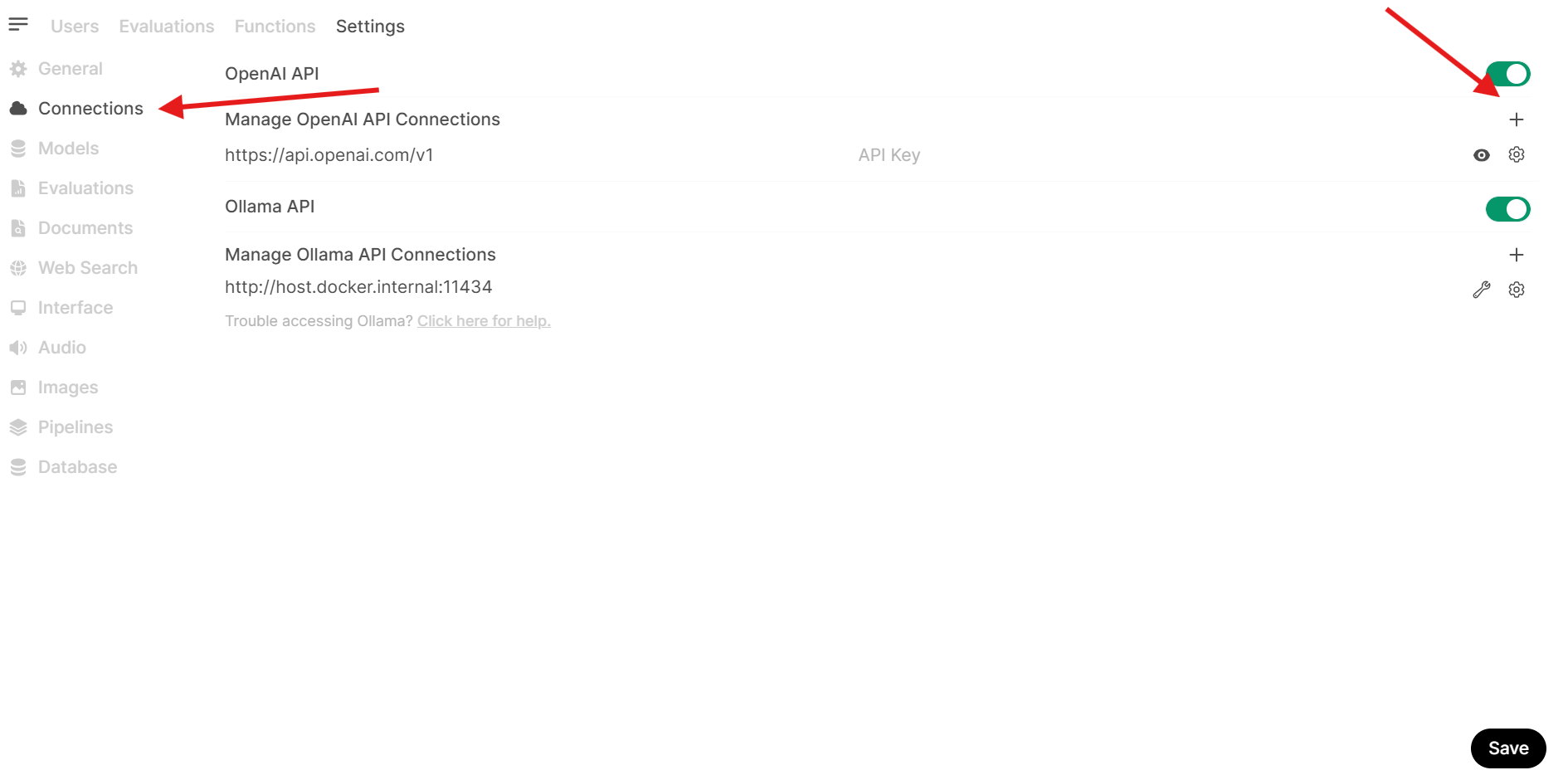

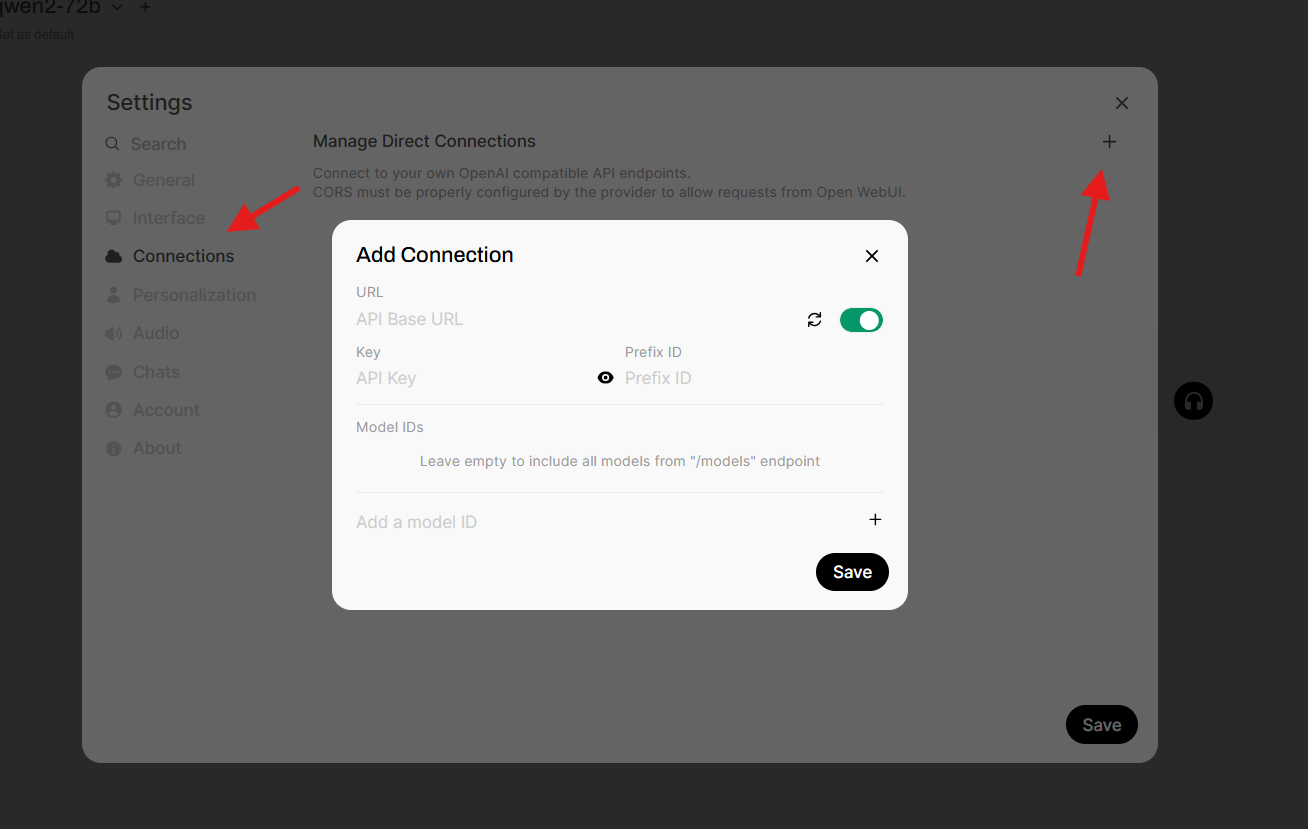

W sekcji Admin Settings wybierz Connections.

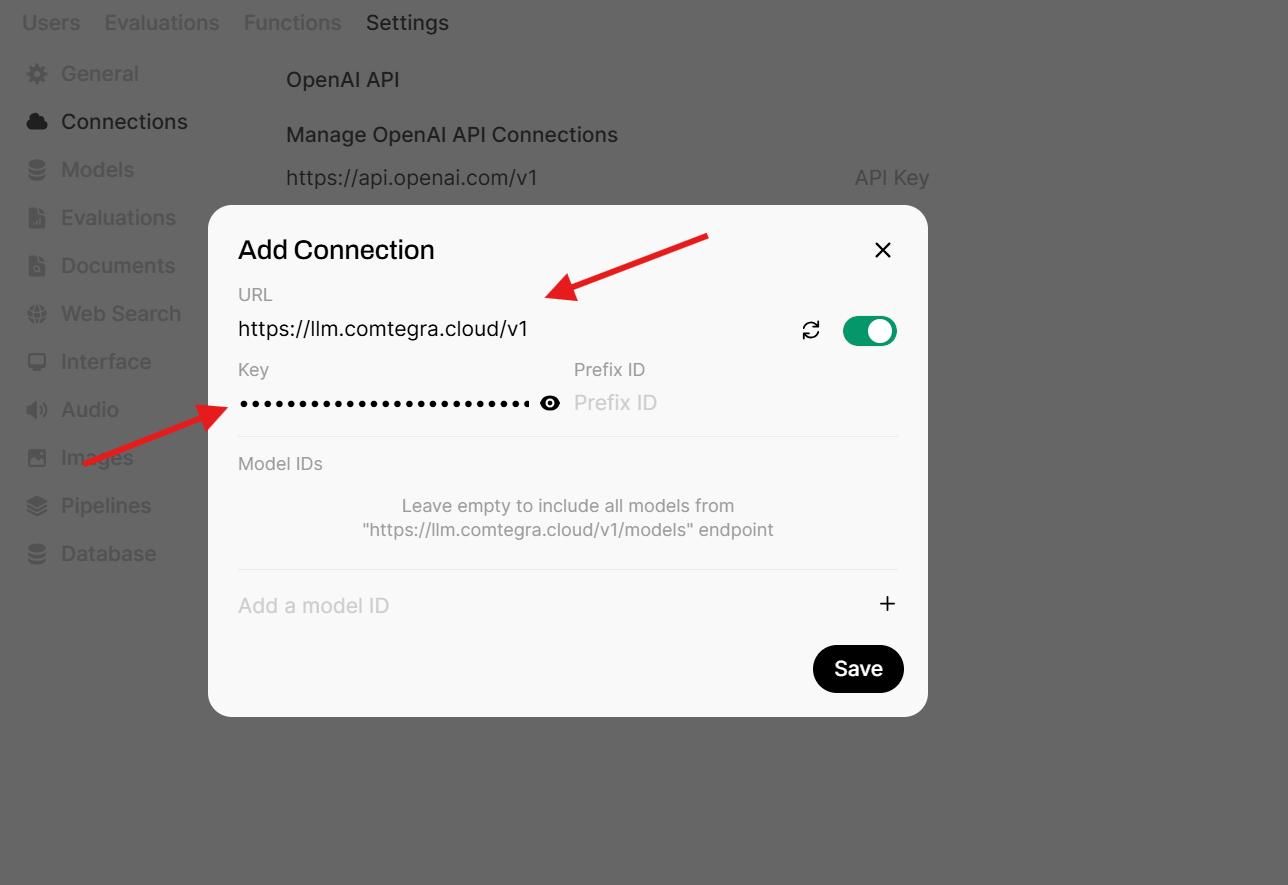

W oknie Add Connection wypełnij pola URL i API Key wartościami z LLM-API lub zasobu obliczeniowego LLama.cpp, który utworzyłeś wcześniej.

Korzystając z LLM API nie musisz określać ID modelu, ponieważ OpenWebUI automatycznie wykryje i będzie używać dostępnych modeli z LLM API poprzez endpoint models.

Konfiguracja dostawcy LLM jako użytkownik

OpenWebUI od wersji v0.5.12 wprowadził możliwość konfiguracji dostawcy LLM jako użytkownik, dzięki czemu nie trzeba polegać na kluczu API konta Administratora.

Przejdź do ustawień na koncie użytkownika, a poźniej do sekcji Połączenia.

W sekcji połączenia dodaj bezpośrednie połączenie.

W oknie Add Connection wypełnij pola URL i API Key wartościami z LLM-API lub zasobu obliczeniowego LLama.cpp, który utworzyłeś wcześniej.

Korzystając z LLM API nie musisz określać ID modelu, ponieważ OpenWebUI automatycznie wykryje i będzie używać dostępnych modeli z LLM API poprzez endpoint /models.

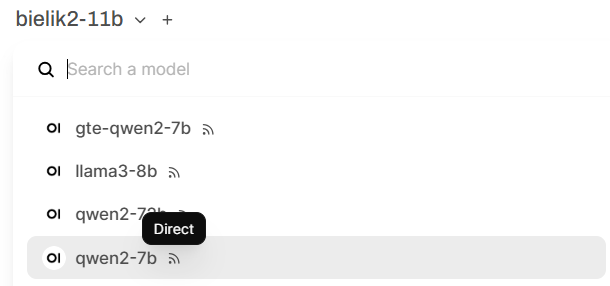

Bezpośrednie modele będą wyświetlane z etykietą Direct.

Używanie OpenWebUI

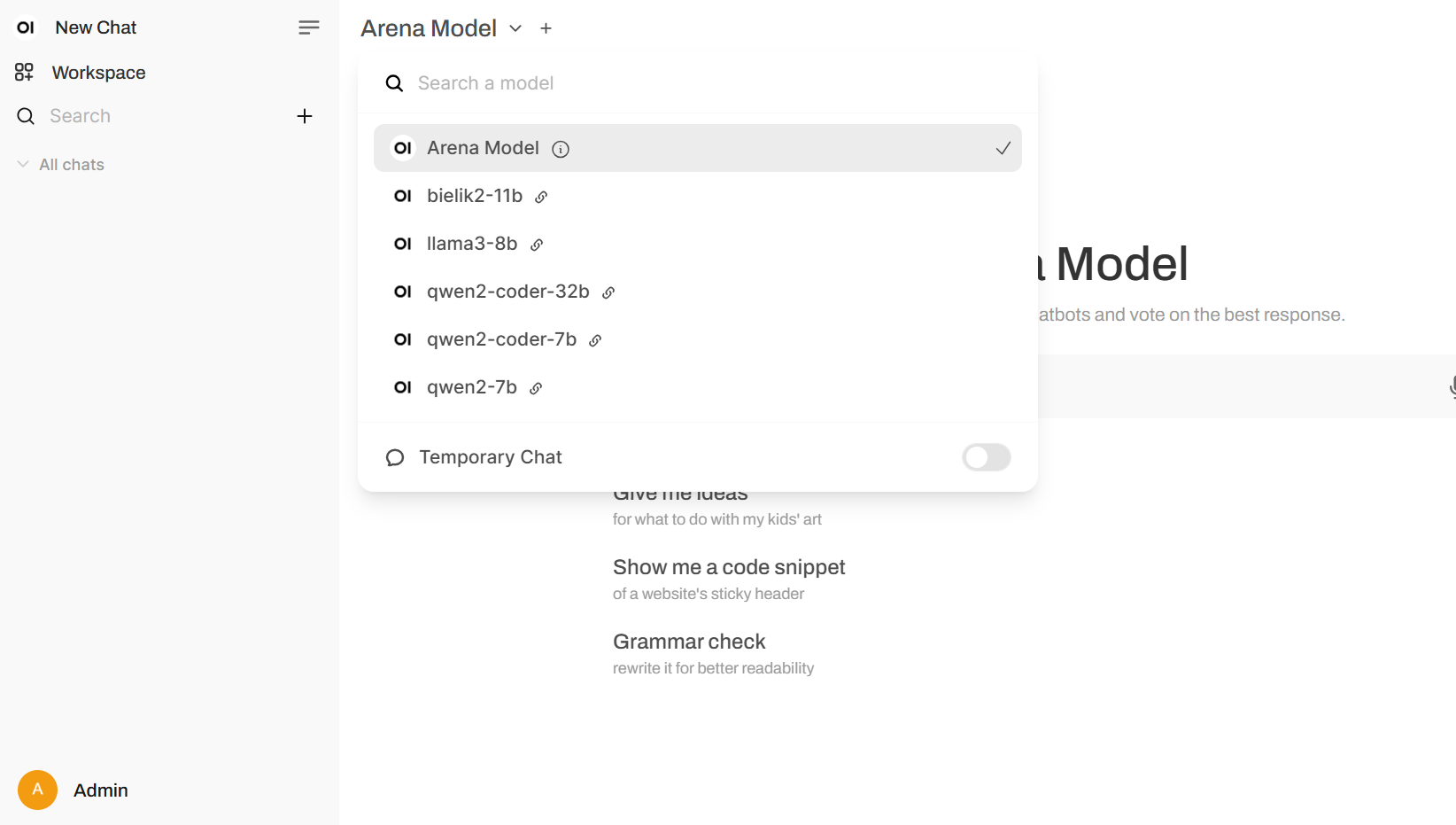

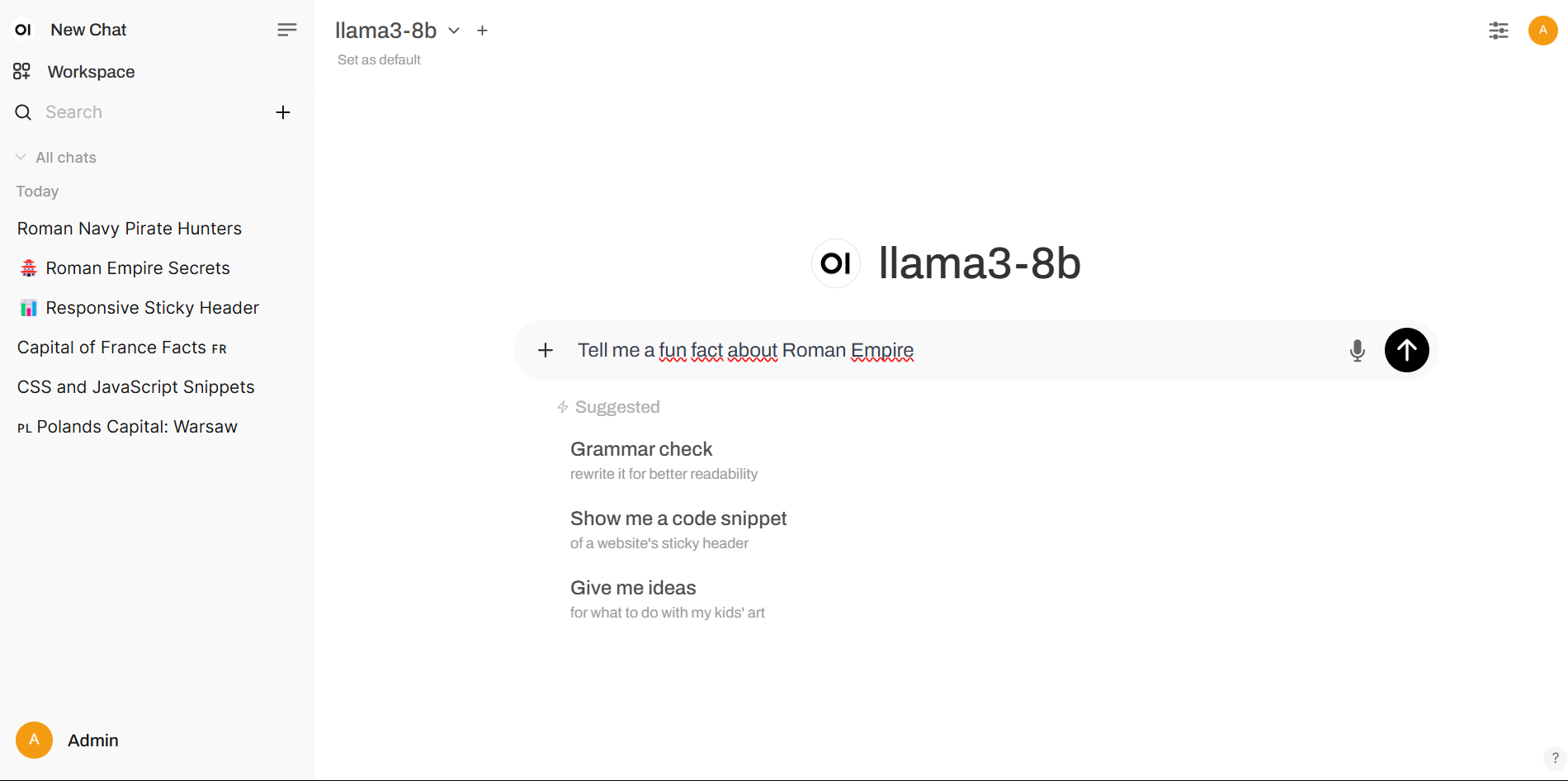

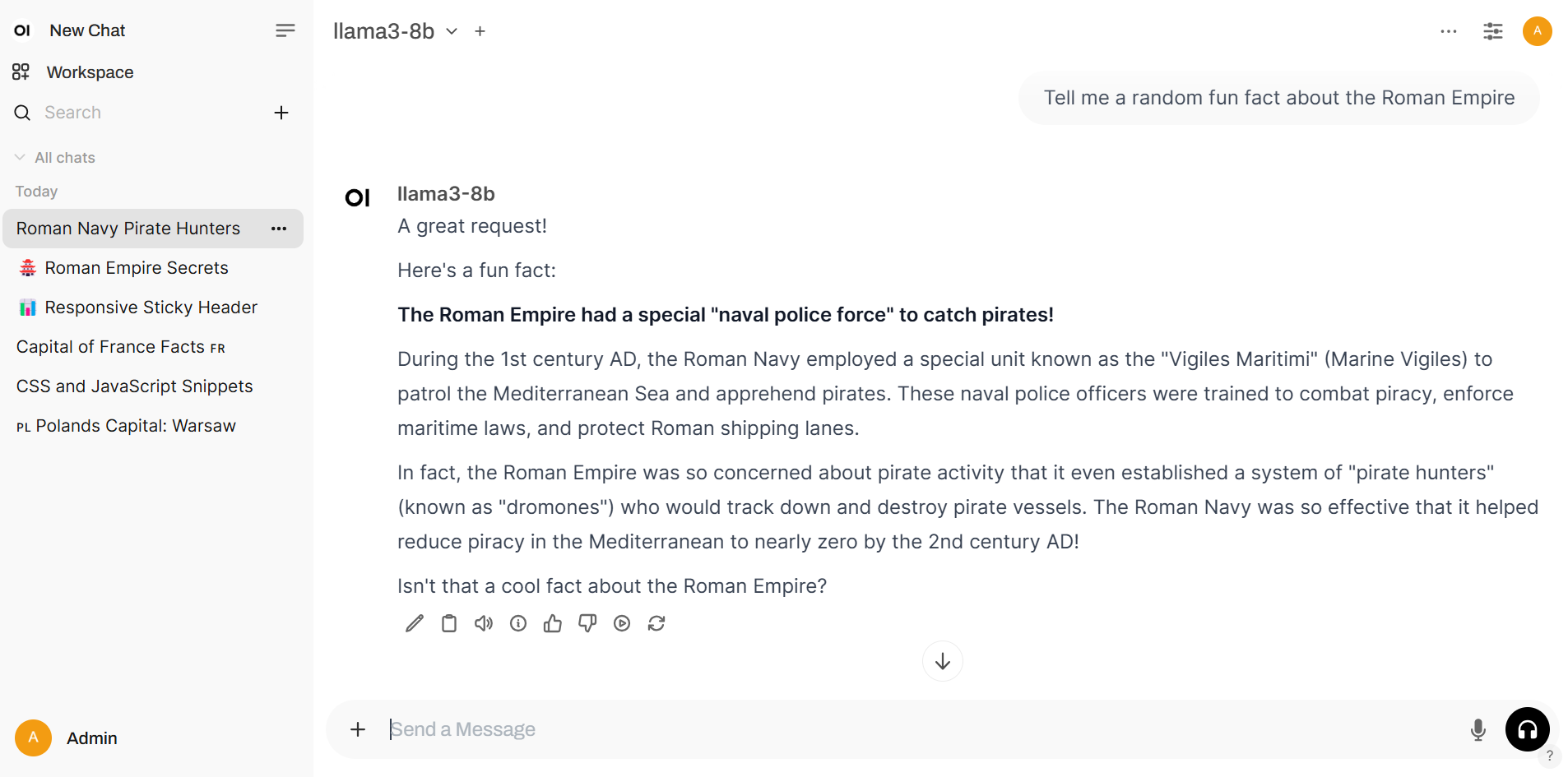

Aby odpytać LLM, wybierz model z listy dostępnych modeli.

Po wybraniu modelu możesz użyć interfejsu chatu. Zadaj swoje pytanie w polu tekstowym i naciśnij Enter, aby wysłać swoją wiadomość.

Gotowe! Możesz teraz rozmawiać z LLM.

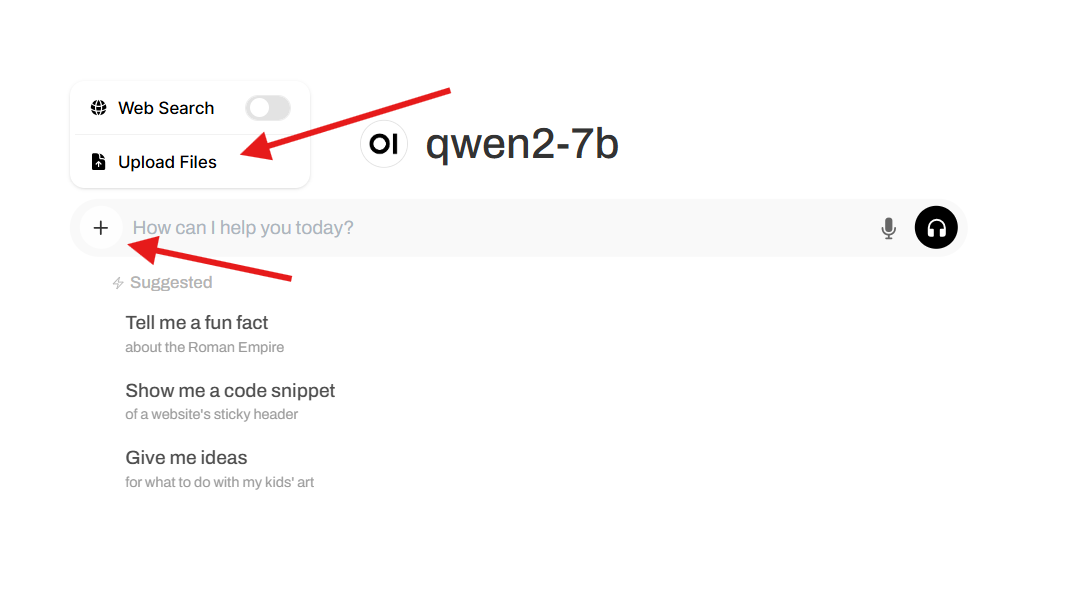

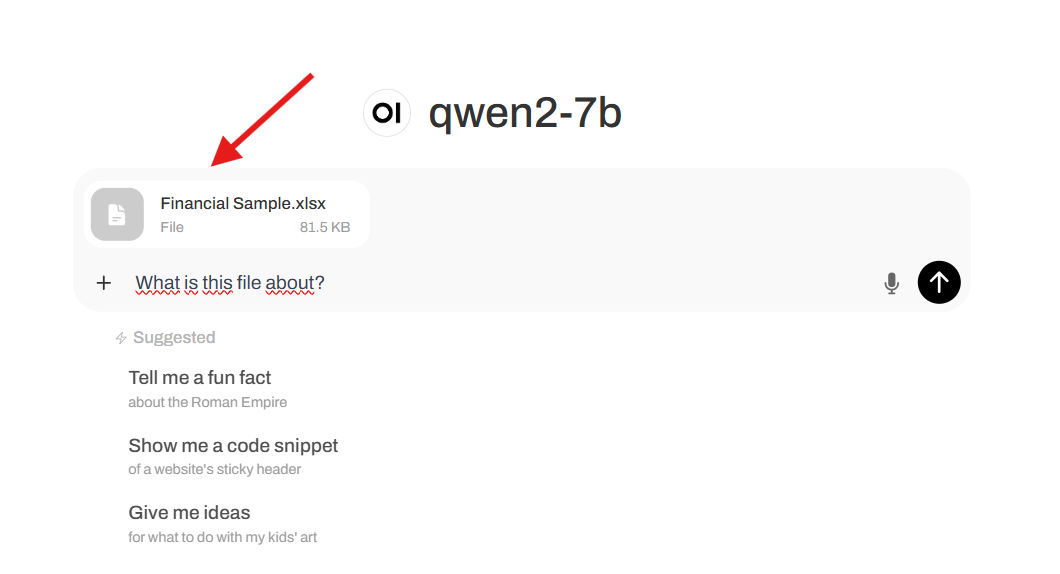

Przesyłanie plików

OpenWebUI pozwala na przesyłanie plików do interfejsu chatu. Aby to zrobić, kliknij przycisk plus po lewej stronie interfejsu chatu lub przeciągnij plik do interfejsu chatu.

Po przesłaniu pliku, zobaczysz go w interfejsie chatu. Teraz możesz zadać pytanie LLM o treść pliku lub użyć pliku jako kontekstu dla rozmowy.

Obsługiwane formaty plików:

- .txt

- .json

- .csv

- .docx

- .pptx

- .xlsx

- .md

Wyszukiwanie w sieci

OpenWebUI pozwala na wyszukiwanie w sieci.

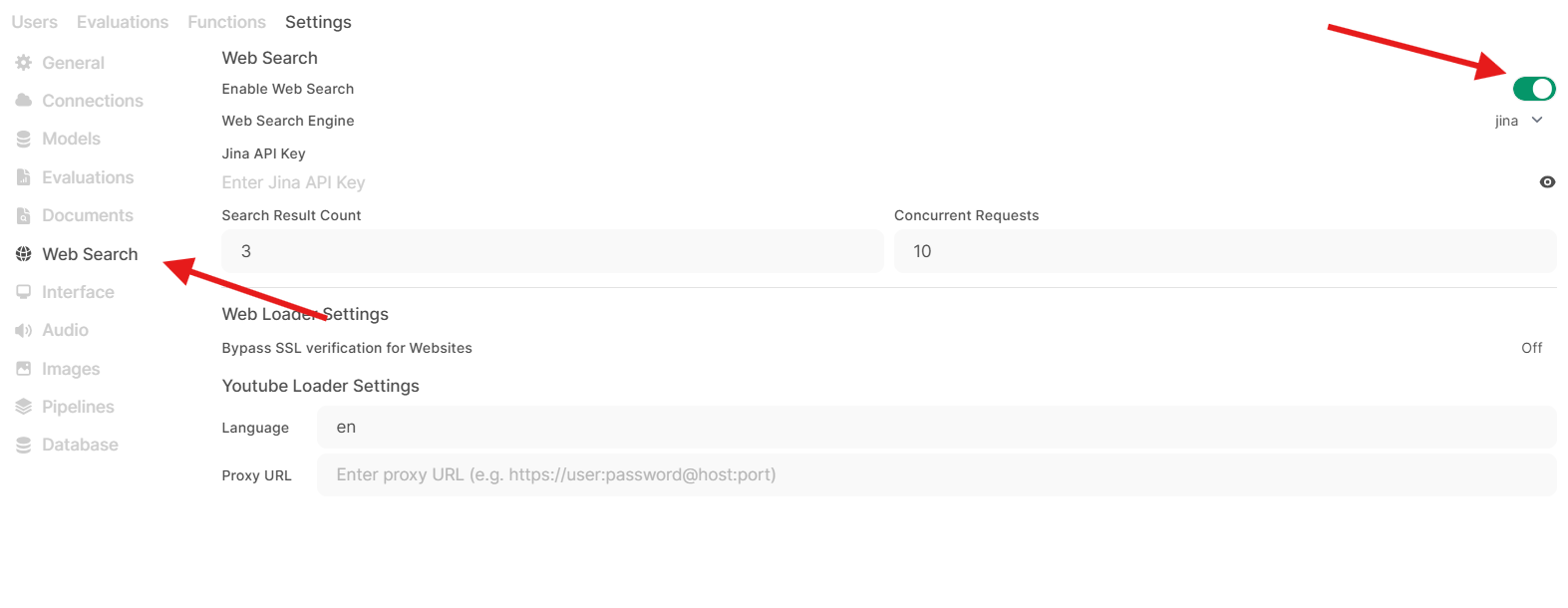

Aby wyszukać w sieci, musisz podać klucz API wyszukiwarki. Aby to zrobić, otwórz panel ustawień:

Kliknij na Admin Settings.

W panelu ustawień admina wybierz Web Search.

W panelu Web Search włącz przycisk Web Search. Podaj klucz API i kliknij Save.

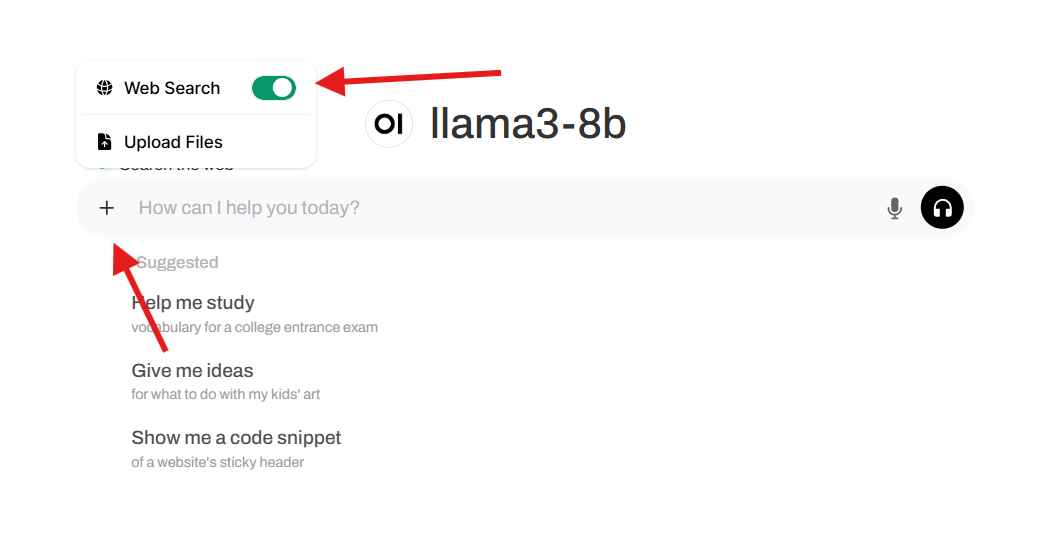

Teraz możesz wyszukiwać w sieci. Kliknij przycisk Web Search w interfejsie chatu i wpisz swoje pytanie.

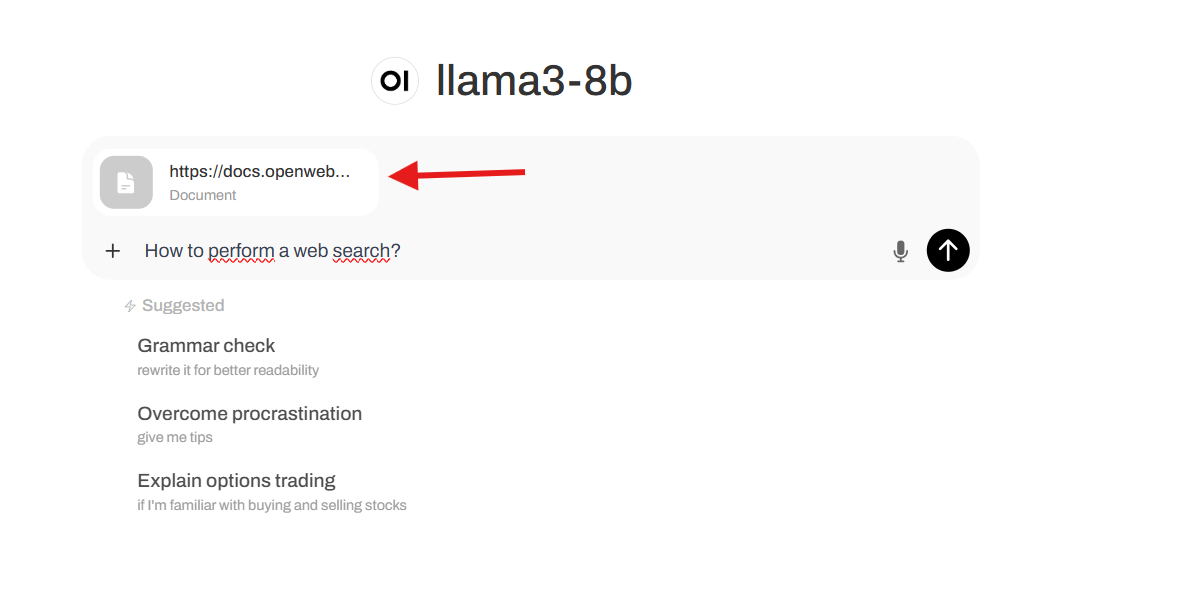

Używanie strony internetowej jako kontekstu

OpenWebUI pozwala na używanie strony internetowej jako kontekstu dla rozmowy. Aby to zrobić, wpisz "#webpage" w interfejsie chatu i w miejsce webpage wklej URL strony internetowej.

Strona powinna być widoczna jako kontekst w interfejsie chatu. Twoja wiadomość powinna wyglądać następująco:

Po zadaniu pytania, LLM powinien odpowiedzieć na pytanie na podstawie strony internetowej.

Tworzenie użytkowników

Aby stworzyć nowych użytkowników, przejdź do Admin Panel w OpenWebUI.

W panelu admina naciśnij przycisk + aby stworzyć nowego użytkownika.

W formularzu Add user wypełnij rolę, imię, e-mail i hasło dla nowego użytkownika.

Wyślij e-mail i hasło użytkownikowi, z ich pomocą będzie on mógł się zalogować do OpenWebUI.

Jak włączyć użytkownikom dostęp do modeli LLM

Istnieją dwa sposoby na włączenie użytkownikom dostępu do modeli LLM:

1. Dodawanie użytkowników do grupy

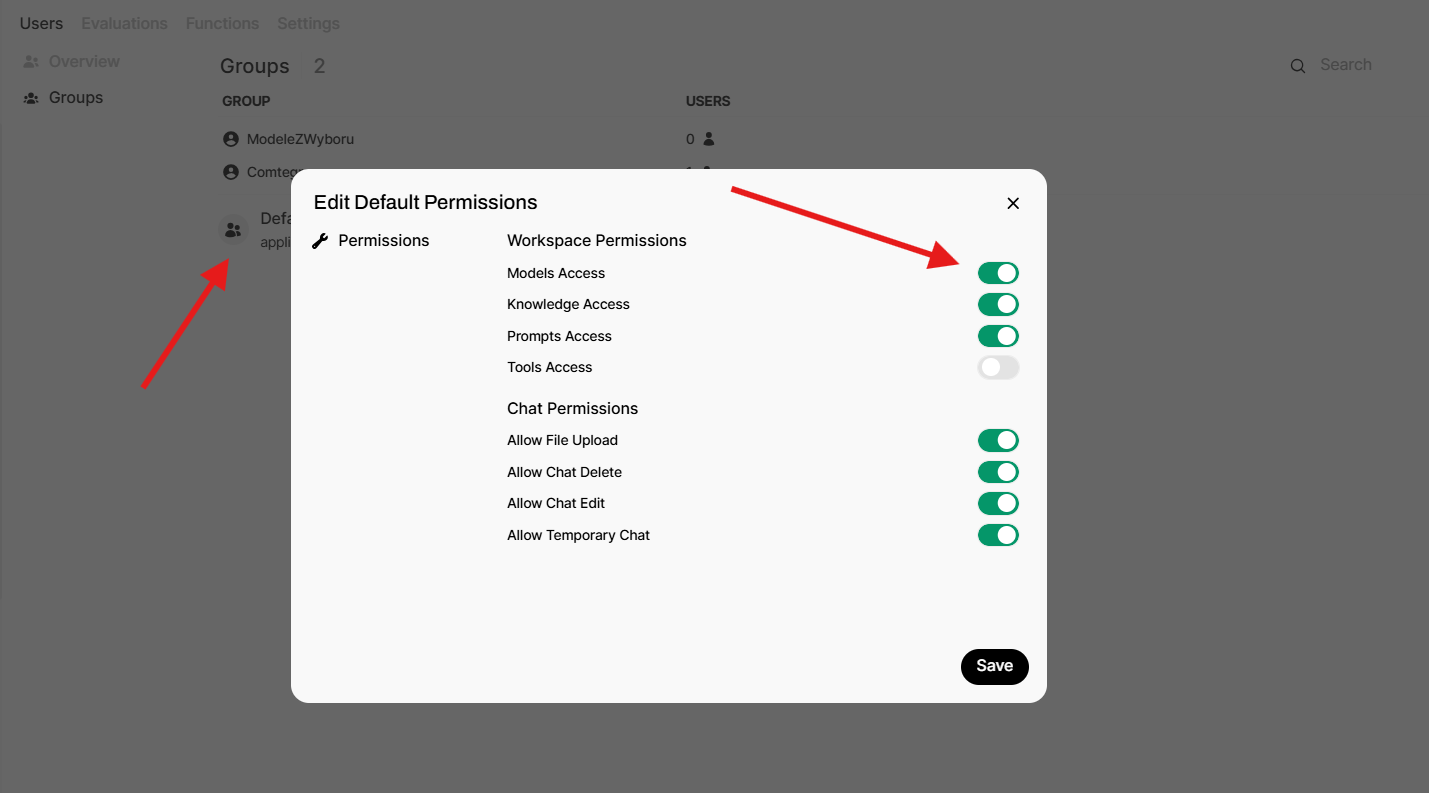

To jest zalecany sposób na włączenie użytkownikom dostępu do modeli LLM. Aby dodać użytkownika do grupy, przejdź do Admin Panel w OpenWebUI i przejdź do sekcji Groups.

Naciśnij przycisk + aby stworzyć nową grupę.

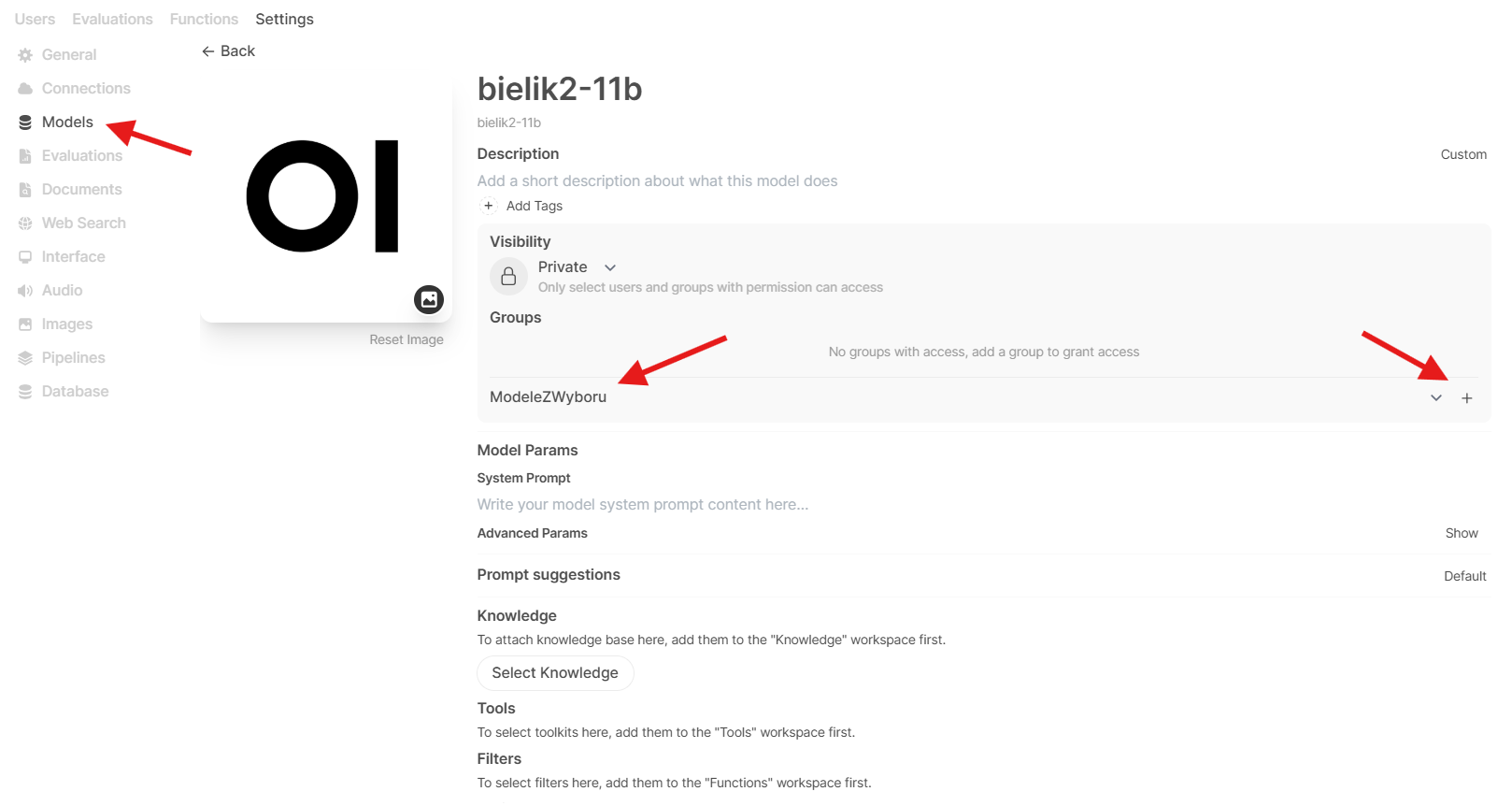

Po stworzeniu nowej grupy, zobaczysz ją na liście grup. Kliknij na nią aby ją otworzyć. Tutaj możesz dodać użytkowników i zmienić uprawnienia grupy. W ustawieniach grupy włącz opcję Models Access i naciśnij Save.

Teraz możesz dodać model do grupy. Przejdź do Admin Settings i wybierz sekcję Models. Kliknij na model, który chcesz dodać do grupy i naciśnij Select a group. Naciśnij + aby dodać model do grupy i Save.

Gotowe! Teraz użytkownicy z grupy będą mieli dostęp do wybranych modeli.

2. Dostęp do wszystkich modeli

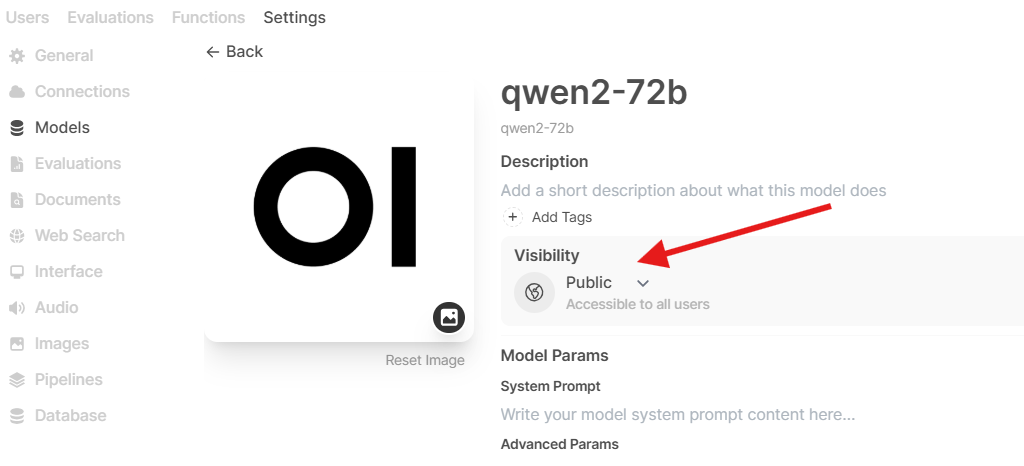

To jest prostszy sposób na włączenie użytkownikom dostępu do modeli LLM, może być jednak mniej bezpieczny.

Uwaga: Jeśli nie ma grup z dostępem do modeli, upewnij się, że wszyscy użytkownicy mają włączony dostęp do modeli.

Żeby włączyć dostęp do wszystkich modeli, przejdź do Admin Settings i wybierz sekcję Models. Kliknij na model, który chcesz udostępnić wszystkim użytkownikom i zmień jego widoczność na Public.

Gotowe! Teraz wszyscy użytkownicy będą mieli dostęp do wybranych modeli.

Po więcej informacji na temat OpenWebUI, zapraszamy do oficjalnej dokumentacji OpenWebUI.